Momentum Gradient Descent

# Tag:

- Source/KU_ML2

toc test

Momentum Gradient Descent

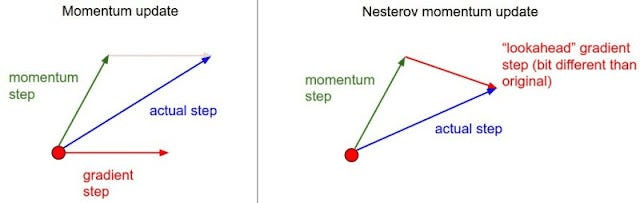

gradient만 빼주어 update하는게 아니라, 이전에 갔던 방향의 graident를 같이 빼주어 이전에 갔던 방향으로의 관성을 추가해주는 Gradient Descent.

이전의 갔던 방향으로의 관성이 추가되므로, 기존의 방식보다 local mininum으로 더 빠르게 도착할 확률이 늘어난다. 또한, local minumun에 갇히지 않을 확률도 늘어나게 된다.

이전 방향의 gradient와, 현재 방향의 gradient의 weighted sum이라 할 수 있다.

일종의 moving average로, 에 따른 전체에 대해서 보면 weighted sum이다.

Nesterov's Accelerated Momentum(NAV)

이전의 gradient 방향으로 일단 이동한 후, 그 지점에서 다시 gradient를 구해 이전에 갔던 방향의 gradient와 같이 빼주는 방법.